Flash-解决更新风暴、长尾到达的最新数据平面验证-学习3

本次是Flash实验评估

评估

1 | 回答四个关键问题 |

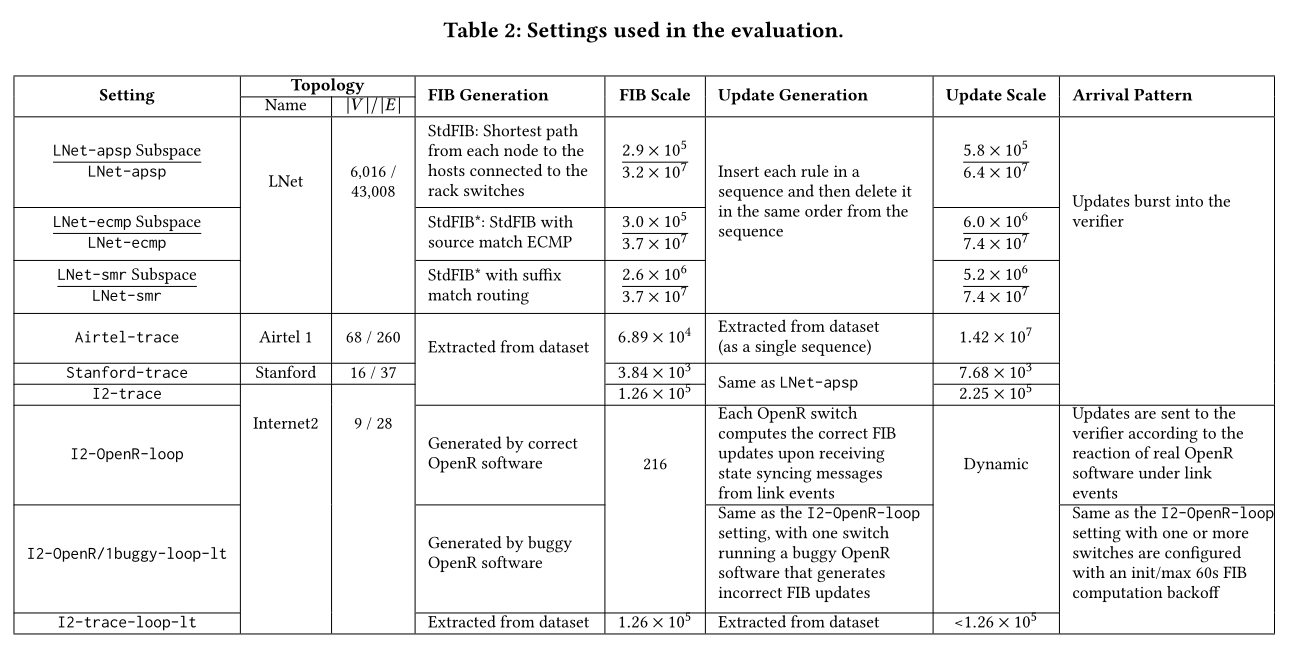

实验设置

1 | 快速IMT命名方式:A-B,其中A代表网络拓扑,B代表FIB生成 |

评估基准

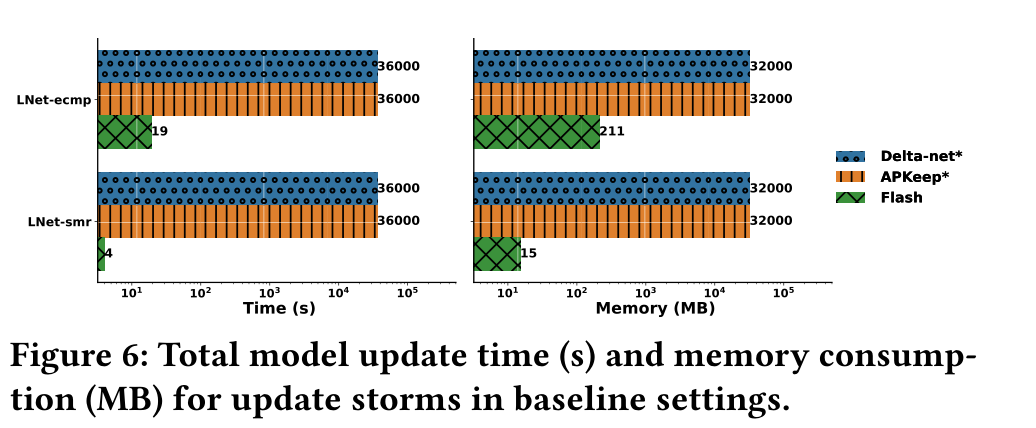

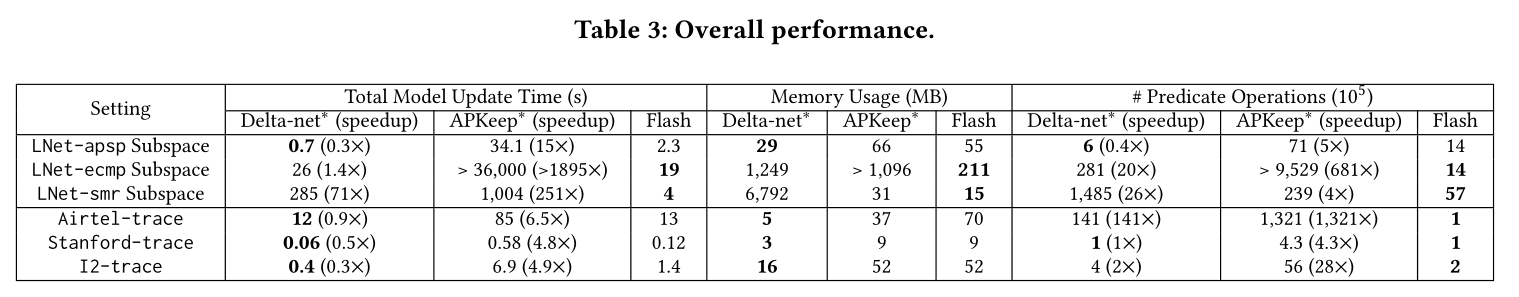

评估1:在大规模网络(LNet-ecmp和LNet-smr)中评估

1 | 作者通过将所有交换机的规则插入放在一个序列中来生成更新,将更新序列提供给验证器,并测量执行时间和内存消耗来构建反向模型。如果执行时间超过10小时,我们将终止JVM。 |

评估2:快速IMT的优势和稳健性。

1 | 作者分析了快速IMT作为一种独立的模型构建方法的好处,通过将子空间划分思想应用于大型网络中的Delta-net*和APKeep*,因为子空间划分可以广泛有效地用于大型网络。 |

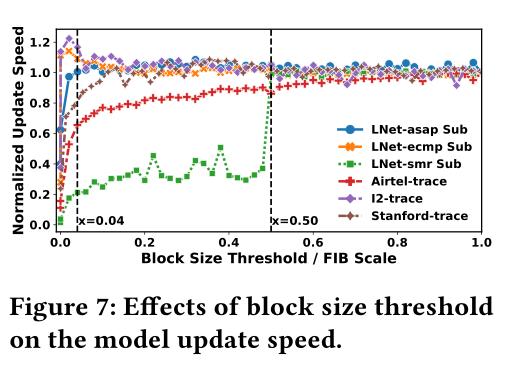

评估3:与CE2D合作时块大小阈值的影响。

1 | 由于更新可能在实际中不断到达,Flash可以选择更新反向模型,并在处理所有规则更新之前执行CE2D。 |

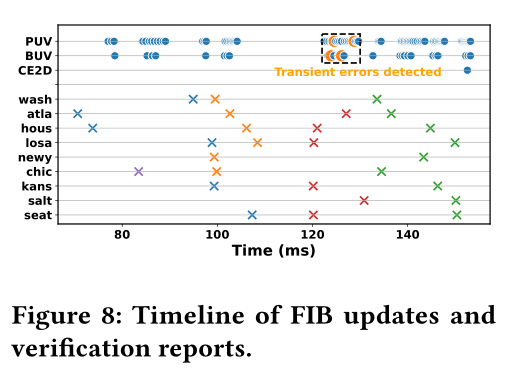

评估4:CE2D评估,证明其在极端环境下的有效性、性能优势和稳健性。

1 | 实验设计: |

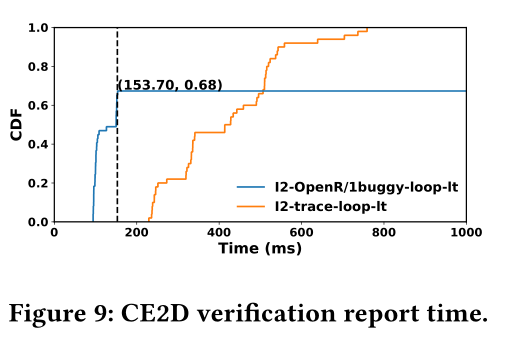

评估5:CE2D对长尾到达的好处。证明当长尾到达发生时,CE2D可以提高多少性能。

1 | 实验设计: |

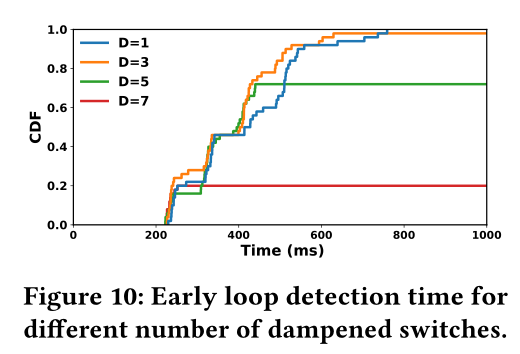

评估6:多重阻尼交换机的影响。即研究了当存在多个阻尼交换机时对CE2D的影响。

1 | 实验设计: |

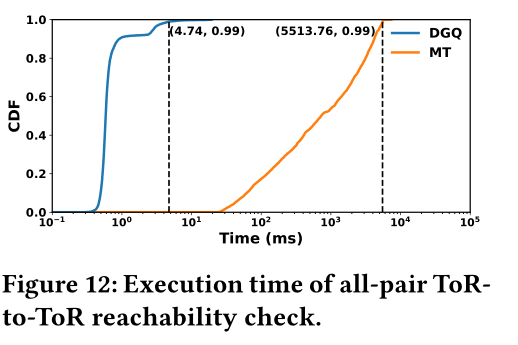

评估7:大规模网络中PAT的影响。

1 | 实验设计: |

评估8:MR2的影响。即为了更好地理解MR2(§3.2)如何对Flash的整体性能增益做出贡献

1 | 实验设计: |

评估9:递减验证图的效率。即展示了使用递减验证图方法(§4.2)对基于正则表达式的需求执行一致早期检测的效率

1 | 实验设计: |

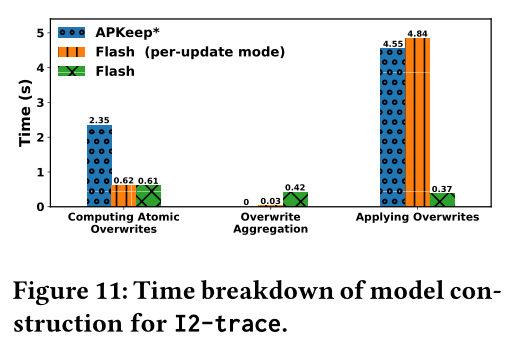

评估10:计算开销

1 | 实验设计: |